模型上下文协议(MCP)的应用:为自主代理、智能合约与创作者经济提供去中心化AI编排

作者:Amit Kumar Jaiswal博士,Endless CTO

模型上下文协议(MCP) 是一个由Anthropic引入的开源通信框架,旨在标准化AI大模型、应用程序和去中心化系统之间的交互。它作为一个中间件层,功能类似于“通用适配器”,能够实现异构AI代理、API和区块链网络之间的无缝数据交换、持久连接、上下文保持和互操作性,摆脱了传统的一次性API调用方式。

为什么需要MCP?

现有的大型语言模型(LLM)驱动系统具有静态的输入/输出结构,难以实现实时协作和动态信息使用。由于每次交互都需要传递上下文,这些系统效率低下,且与多种工具和数据源的集成复杂且非标准化。MCP解决了这些问题,使LLM能够作为对话代理,访问实时信息,主动调用外部工具,并保持上下文。

MCP的关键特性:

标准化通信:MCP定义了结构化协议,确保AI模型在交换上下文数据时不丢失语义含义。

去中心化互操作性:促进分布式环境中AI代理之间的交互,包括Web3和区块链生态系统。

上下文保持:在多轮对话和涉及多个AI模型的复杂工作流中保持连续性。

安全性:提供权限控制、身份验证和数据完整性。

MCP在需要AI模型动态协作的场景中尤为重要,例如自主代理、去中心化AI市场和跨链智能合约。

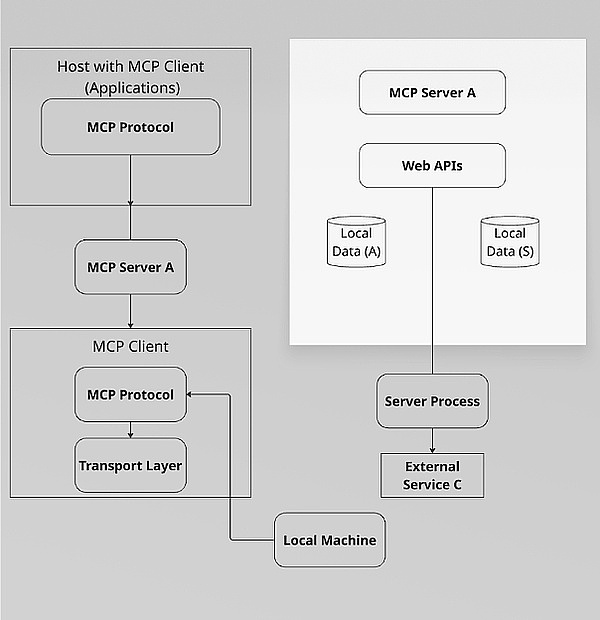

MCP的核心组件

MCP基于客户端-服务器架构,支持AI模型与外部数据源之间的无缝通信。其主要组件包括:

1. 本地机器

定义:MCP系统运行的本地环境(用户设备或服务器)。

角色:

托管MCP客户端和主机应用程序。

通过协调本地和远程MCP服务器执行AI工作流。

2. 主机

定义:管理MCP客户端和AI集成的中央编排者。

功能:

MCP客户端管理:

创建和终止MCP客户端(例如,每个MCP服务器对应一个客户端)。

强制执行身份验证和会话策略。

上下文聚合:合并多个MCP客户端的输出(例如,将LLM响应与数据库查询合并)。

安全与合规:应用用户同意规则(例如GDPR)和数据访问控制。

AI协调:将请求路由到适当的AI模型(例如Claude、GPT-4)通过MCP客户端。

示例:Claude聊天机器人应用、VSCode AI插件或去中心化AI代理平台。

3. MCP客户端

定义:由主机创建的轻量级进程,用于与单个MCP服务器交互。

功能:

有状态会话:维护与MCP服务器的持久连接(例如WebSocket)。

协议协商:处理版本控制、加密(TLS)和数据序列化(JSON/Protobuf)。

消息路由:主机与MCP服务器之间的双向通信。

发布/订阅管理:订阅事件驱动的更新(例如,实时AI推理结果)。

关键特性:

每个MCP服务器对应一个客户端以实现隔离。

实现故障转移机制以确保可靠性。

4. MCP服务器

定义:暴露AI模型、工具或数据源的专用服务器。

角色:

资源暴露:提供对LLM(例如GPT-4)、数据库或API(例如天气数据)的访问。

去中心化执行:独立运行,专注于特定职责(例如,仅限文本摘要)。

采样与推理:处理MCP客户端请求(例如,生成AI响应)。

安全性:根据访问策略验证请求(例如,速率限制)。

消息经纪人:使用发布/订阅机制(例如MQTT、Redis)进行实时AI代理通信。

区块链集成层:智能合约可触发MCP请求,AI响应可记录在链上。

类型:

本地服务器:运行在同一机器上(例如,本地数据源A)。

远程服务器:基于云或链接到区块链(例如,外部服务C)。

5. MCP协议

定义:组件之间的标准化通信层。

技术栈:

传输层:使用HTTP/2、WebSocket或libp2p(用于P2P网络)。

安全性:端到端加密(例如TLS、Noise协议)。

6. 数据流示例

用户请求:通过主机发送查询(例如,“获取新闻并总结”)。

MCP客户端路由:主机生成两个MCP客户端:

客户端1:连接到MCP服务器A(新闻API)。

客户端2:连接到MCP服务器B(LLM摘要)。

执行:

MCP服务器A检索新闻数据 → 通过主机发送到MCP服务器B。

MCP服务器B生成摘要 → 返回给用户。

上下文保持:context_id确保后续查询(例如,“解释第二点”)保留历史记录。

MCP与传统API的对比

MCP通过提供持久连接会话而非离散的单次请求-响应交互,区别于传统应用程序接口。传统API需要每次请求都传递上下文,而MCP能够实时维护和更新上下文。这种方式通过使用单一标准协议提高可扩展性,消除了传统API系统中每个工具需要单独连接的需求。

MCP是使LLM从单纯的文本生成器转变为实时交互系统的核心技术。它促进了AI与各种外部数据源、软件工具和用户界面的直接协作,从而能够执行更复杂的任务。MCP被设想为AI代理生态系统的核心协议,以及“工具使用AI”的标准通信协议,为更复杂和集成的AI应用铺平道路。

与LLM和AI代理的集成

动态模型切换:MCP允许在对话中途切换LLM(例如,从GPT-4切换到Claude 3)而不中断上下文。

多代理工作流:AI代理可通过MCP协作(例如,一个处理图像生成,另一个处理文本)。

细粒度访问控制:MCP可管理去中心化网络中AI模型使用的权限。

MCP在区块链与Web3中的应用

MCP通过作为链上逻辑与链下AI处理之间的桥梁,增强了去中心化AI应用。

使用场景:

去中心化AI预言机

示例:智能合约在执行交易前需要对Twitter数据进行情感分析。

MCP工作流:

智能合约向MCP节点发送请求。

MCP将查询路由到NLP模型(例如GPT-4)。

AI响应通过MCP格式化并返回链上。

AI驱动的DAO

示例:DAO使用AI代理分析治理提案。

MCP工作流:

提案文本通过MCP发送到LLM进行摘要。

摘要输出供DAO成员投票。

DeFi + AI风险评估

示例:借贷协议使用MCP获取AI生成的信用评分。

技术实现:

MCP获取链上交易历史+链下信用数据。

AI模型处理后通过MCP返回风险评分。

在Endless AI生态系统中实现去中心化AI代理协调

Endless AI利用MCP为Endless生态系统中的AI集成提供统一和标准化的方法。通过结合MCP与Endless的隐私保护机制(如零知识证明(ZKP)和KZG承诺),该协议确保AI代理在访问和利用外部上下文时的交互既可验证又符合隐私标准。这意味着AI代理可以利用外部数据增强性能,同时整个过程可通过链上审计,用户的隐私通过加密证明和数据隔离得到保护。

AI模型作为微服务:每个模型作为一个MCP节点,允许无缝组合(例如,GPT-4 + Stable Diffusion)。

基于区块链的货币化:

用户通过加密货币支付以通过MCP访问AI服务。

智能合约审计MCP交互以确保公平性。

跨平台AI代理:Endless AI的代理使用MCP与Web2和Web3应用交互。

Luffa(SocialFi平台):MCP连接AI策展者以个性化信息流,同时通过零知识证明保护隐私。

AI-NFT铸造:创作者使用MCP验证原创性后再铸造NFT。

DeFi代理群:自主交易者使用MCP实时分析跨链流动性。

MCP标准化了上下文感知交互,确保AI代理保留记忆、适应实时数据并跨领域协作。

A. 代理AI与自主AI代理

上下文感知AI群:

MCP允许AI代理跨会话共享上下文(例如,用户偏好、交易历史)。

示例:DeFi交易代理使用MCP记住用户的风险容忍度并动态调整策略。

多代理协作:

代理通过MCP格式化消息进行协商(例如,一个代理处理NLP,另一个执行交易)。

用例:Luffa(Endless的SocialFi平台)中的AI审查者协作检测有害内容。

B. DeFi与智能合约

AI驱动的预言机:

MCP获取链下数据(例如,市场情绪)以触发智能合约。

示例:借贷协议使用MCP获取AI生成的信用评分。

自主DeFi代理:

代理通过MCP与流动性池交互,根据实时分析优化收益。

C. 大型语言模型与AIGC

动态模型切换:

MCP将查询路由到最适合的LLM(例如,GPT-4用于文本,Claude用于代码)。

用例:Endless的NFT市场中的艺术家通过MCP连接的Stable Diffusion生成AI艺术。

链上IP归属:

MCP为AI生成内容添加时间戳,铸造为带有版税的NFT。

D. 去中心化AI训练(有用工作证明,PoUW)

通过MCP的联邦学习:

AI模型在用户拥有的数据上训练,无需集中收集(保护隐私)。

MCP从分布式节点聚合模型更新。

场景:Endless AI的MCP驱动聊天机器人

用户查询 → MCP路由器 → 最适合的LLM(基于成本/速度)。

响应通过MCP格式化并返回给用户。

支付通过链上加密货币结算。

总结

MCP是AI互操作性的变革者,特别是在区块链和Web3生态系统中。通过标准化AI通信、启用去中心化工作流和增强LLM协作,MCP为下一代自主、可组合的AI系统奠定了基础。

Endless AI计划扩展MCP以实现:

AI to AI智能合约:代理自主协商交易(例如,授权AI艺术)。

抗量子MCP:抵御未来加密威胁。

自我进化的AI生态系统:MCP将使AI群通过去中心化学习自我优化。

声明:本文由入驻金色财经的作者撰写,观点仅代表作者本人,绝不代表金色财经赞同其观点或证实其描述。

提示:投资有风险,入市须谨慎。本资讯不作为投资理财建议。

24小时热文

金色Web3.0日报 | Phantom暗示将上线预测市场

金色Web3.0日报 | Phantom暗示将上线预测市场金色财经 善欧巴

英国《金融时报》:为什么全世界都应该对稳定币感到担忧

英国《金融时报》:为什么全世界都应该对稳定币感到担忧Block unicorn

Strategy 硬刚 MSCI: DAT 的终极辩护

Strategy 硬刚 MSCI: DAT 的终极辩护Foresight News

火币HTX正式获核准交易所牌照登记

火币HTX正式获核准交易所牌照登记火币HTX

资本大佬卖飞英伟达的往事

资本大佬卖飞英伟达的往事道说区块链

用户比Coinbase多3倍 估值高53%:市场为何更爱Robinhood?

用户比Coinbase多3倍 估值高53%:市场为何更爱Robinhood?比推 Bitpush News

当发币变成流水线有人在给比特币开发者发工资

当发币变成流水线有人在给比特币开发者发工资白话区块链

财富效应消失后——去中心化的神话或悲歌

财富效应消失后——去中心化的神话或悲歌佐爷歪脖山

- 寻求报道

金色财经APPiOS & Android

金色财经APPiOS & Android- 加入社群

Telegram - 意见反馈

- 返回顶部

- 返回底部